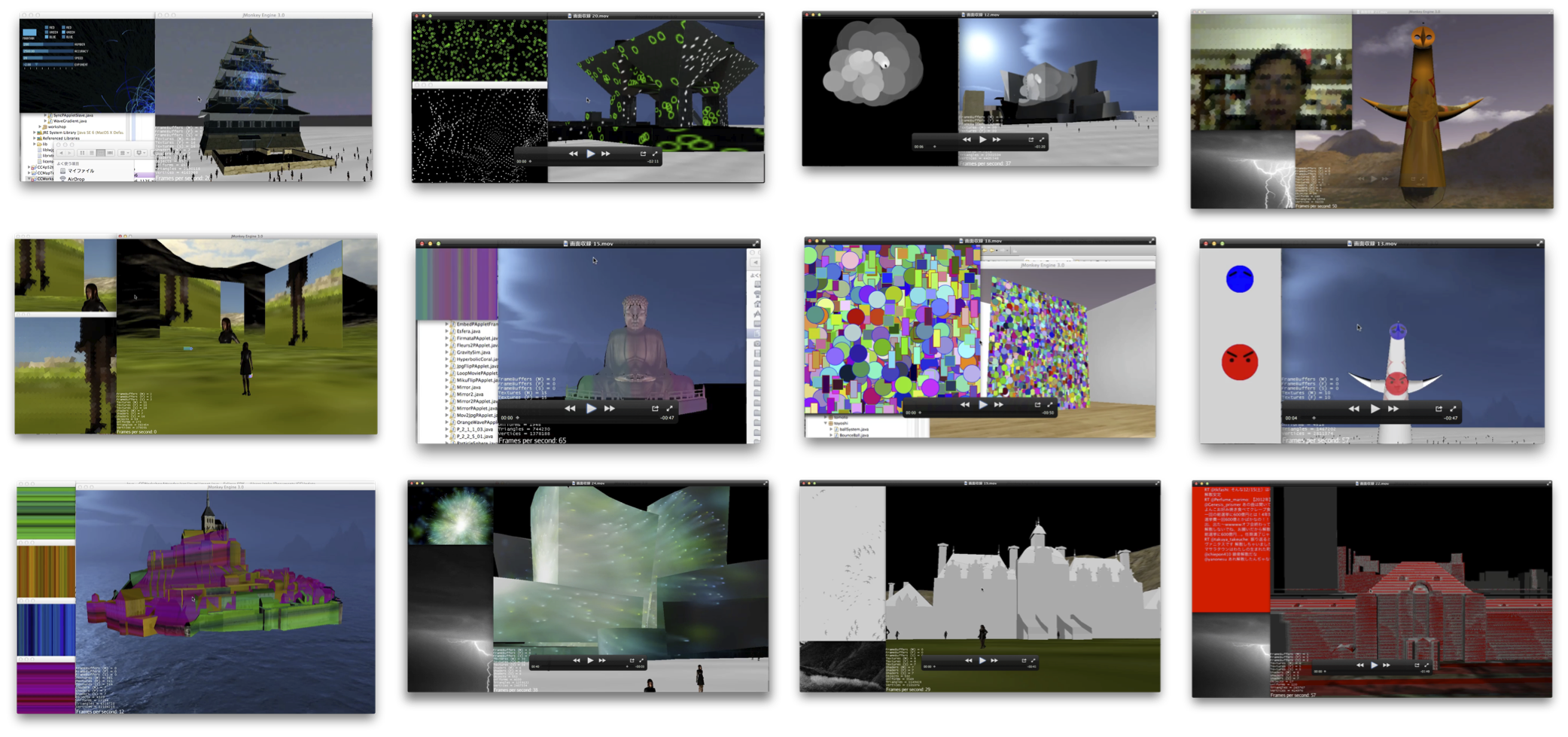

CityCompilerOnMikuMikuStudio OpticalFlow from Yasuto Nakanishi on Vimeo.

CityCompilerはjMonkeyEngineというゲームエンジンを使っていますが,同じゲームエンジンを使ったプロジェクトにMikuMikuStudioがあります.MikuMikuStudioは,MikuMikuDanceのデータを読み込んで表示することができますが,jMonkeyEngineはJavaで書かれていて,Androidのアプリを作ることもできます.そうして作られているのがTinyARというAndroidアプリで,スマホの中でミクさんが踊る様子を色んな方向から見ることができます.

MikuMikuStudioはNetBeansをベースにつくられた開発環境jmonkeyplatformをベースにつくられた開発環境です.ふだんCityCompilerを使う時はEclipseを使って開発しているのですが,MikuMikuStudioにCityCompilerのクラスが使えるようにライブラリなどをコピーして,使ってみました.

まず,仮想カメラをミクさんの前に置いて,後ろに巨大スクリーンを置きました.あとミクさんの周りを動くカメラとディスプレイも置いてみました.特に理由はなかったのですが,別のプロジェクトでオプティカルフローのことを調べていたので,OpenProcessingのサイトにあったProcessingのスケッチOptical Flowをダウンロードしました.

仮想カメラからの画像をこのスケッチに渡すように設定して,それぞれのディスプレイに結果を表示してみました.ミクさんとカメラとディスプレイの位置は最初は適当に配置しますが,GUIを使ってディスプレイを移動して試行錯誤している間に「予期せぬ発見」がありました.

ミクさんとカメラとディスプレイがうまく並ぶと,合わせ鏡のように映像の中に映像がはいっていきます.ミクさんの動きに反応して描画されたグラフィクスの動きにさらにオプティカルフローの処理がかかって,色の線の爆発?が起きるようになりました.

最初はフェス会場にミクさんを降臨させて,巨大ディスプレイでミクさんの姿にエフェクトがかかった演出の様子をシミュレーションしようとしたのですが,機材の空間的な配置を検討している中で,まったく予期しないアイデアが降臨しました.これも神々しいミクさんのお陰だと思います.